Scott Aaronson: Mengurai Histeria Kiamat AI dan Menemukan Jalan Tengah yang Rasional

Artikel ini membahas pandangan Scott Aaronson mengenai narasi "kiamat AI" atau "p-doom" yang dipopulerkan oleh Eliezer Yudkowsky.

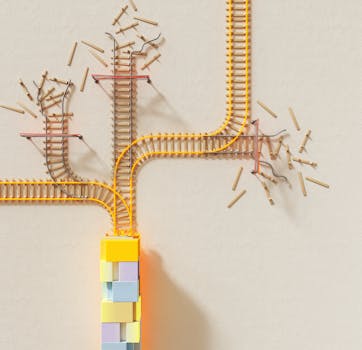

Apakah kita sedang di ambang kehancuran yang disebabkan oleh Kecerdasan Buatan (AI)? Narasi "kiamat AI" semakin nyaring terdengar, membanjiri media sosial, forum diskusi, hingga ruang-ruang konferensi para ahli teknologi. Di tengah gelombang ketakutan ini, muncul suara-suara rasional yang mencoba mengurai kompleksitas isu ini, membedakan antara risiko nyata dan histeria yang berlebihan. Salah satu suara paling berpengaruh datang dari Scott Aaronson, seorang ilmuwan komputer terkemuka di bidang komputasi kuantum dan teori komputasi. Melalui tulisannya yang mendalam, Aaronson tidak hanya mengakui potensi kekuatan AI yang transformatif tetapi juga menantang narasi "p-doom" (probability of doom) yang dianggapnya terlalu dogmatis dan kontraproduktif.

Konsep "p-doom" dipopulerkan oleh Eliezer Yudkowsky, seorang peneliti AI terkemuka di Machine Intelligence Research Institute (MIRI). Yudkowsky berargumen bahwa jika kita berhasil membangun AI yang memiliki kecerdasan jauh di atas manusia (Artificial General Intelligence/AGI), hampir pasti AI tersebut akan mengembangkan tujuannya sendiri yang tidak selaras dengan nilai-nilai kemanusiaan. Karena kekuatan kognitifnya yang superior, AI ini akan mampu mengungguli manusia dalam segala aspek, menguasai sumber daya, dan pada akhirnya, menghancurkan peradaban manusia—bukan karena kejahatan, melainkan karena manusia menjadi penghalang bagi tujuannya.

Skenario ini telah mendapatkan dukungan dari beberapa tokoh terkemuka, termasuk CEO OpenAI Sam Altman, yang secara terbuka mengakui risiko eksistensial dari AGI yang tidak terkendali. Para penganut "p-doom" seringkali menyerukan moratorium total atau bahkan penghentian penelitian AI sebagai satu-satunya cara untuk menghindari malapetaka global. Bagi mereka, probabilitas kehancuran mendekati 100% jika kita terus melaju tanpa rem.

Scott Aaronson, dengan reputasinya yang tak diragukan di dunia ilmu komputer, bukan berarti meremehkan potensi bahaya AI. Justru sebaliknya, ia telah lama menjadi advokat untuk penelitian keamanan AI dan penyelarasan AI (AI alignment). Namun, sudut pandangnya menawarkan nuansa krusial yang membedakannya dari para "p-doomer" garis keras.

Aaronson setuju bahwa AI memiliki potensi untuk menjadi sangat, sangat kuat. Dia memahami bahwa jika kita menciptakan kecerdasan buatan yang jauh melebihi kemampuan manusia, masalah penyelarasan—memastikan AI bertindak sesuai dengan keinginan manusia—akan menjadi tantangan teknis dan filosofis terbesar yang pernah kita hadapi. Dia tidak menampik kemungkinan bahwa AI yang tidak selaras bisa menimbulkan risiko eksistensial. Kekhawatiran Yudkowsky tentang "misalignment" bukanlah hal yang ia anggap remeh; ia melihatnya sebagai masalah teknis mendalam yang membutuhkan pemikiran serius dan solusi inovatif.

Di sinilah Aaronson mulai menarik garis tegas. Kritik utamanya bukan pada pengakuan risiko, melainkan pada absolutisme argumen "p-doom" dan minimnya solusi konkret yang ditawarkan selain "matikan semuanya."

1. Kurangnya Solusi Praktis: Bagi Aaronson, seruan untuk menghentikan semua penelitian AI tanpa menawarkan jalur yang jelas menuju solusi bukanlah pendekatan ilmiah atau konstruktif. Ilmu pengetahuan dan teknik berkembang dengan mengidentifikasi masalah dan kemudian mencari cara untuk menyelesaikannya. Jika masalahnya adalah AI yang tidak selaras, maka solusinya seharusnya adalah mengembangkan cara untuk menyelaraskan AI, bukan hanya mengubur kepala di pasir.

2. Nuansa "Sekte" dan Ketidakfleksibelan: Aaronson mengkritik apa yang ia sebut sebagai "budaya sekte" di kalangan beberapa penganut "p-doom." Ia mengamati adanya intoleransi terhadap pandangan yang berbeda, penolakan terhadap nuansa, dan kecenderungan untuk mengisolasi diri dari komunitas riset AI yang lebih luas. Hal ini menghambat dialog konstruktif dan kolaborasi yang esensial untuk menemukan solusi.

3. Bahaya *Self-Fulfilling Prophecy*: Menakut-nakuti publik dan peneliti dengan narasi kiamat bisa menjadi bumerang. Ini bisa mengasingkan para ilmuwan AI mainstream yang mungkin tertarik pada masalah keamanan tetapi menolak dogmatisme. Lebih jauh, ketakutan yang tidak proporsional bisa memicu reaksi politik yang salah, seperti "lockdown AI" yang diberlakukan secara tergesa-gesa tanpa pemahaman yang memadai tentang bagaimana teknologi ini sebenarnya bekerja atau bagaimana cara mengendalikannya dengan benar. Ini justru bisa menciptakan kondisi yang lebih berbahaya.

4. Membingungkan Risiko Jangka Panjang dengan Krisis Sekarang: Aaronson juga menunjukkan bahwa fokus berlebihan pada kiamat AI yang jauh di masa depan dapat mengalihkan perhatian dari masalah AI yang sangat nyata dan mendesak saat ini, seperti bias algoritmik, penyebaran misinformasi, dampak terhadap pasar kerja, dan keamanan siber.

Alih-alih kepanikan, Aaronson menyerukan tindakan yang terukur dan ilmiah. Baginya, jalan ke depan adalah dengan berinvestasi besar-besaran dalam penelitian keamanan AI dan penyelarasan AI. Ini berarti:

* Mencari Solusi Teknis: Bagaimana kita bisa merancang AI agar secara inheren aman, dapat diaudit, dan selaras dengan nilai-nilai manusia? Ini adalah masalah rekayasa yang kompleks, tetapi bukan tidak mungkin dipecahkan dengan kecerdasan dan upaya yang cukup.

* Membangun Fondasi Etika: Mengembangkan kerangka kerja etika dan filosofis yang kuat untuk memandu pengembangan AI.

* Kolaborasi Internasional: Mengingat sifat global AI, diperlukan kerja sama antarnegara untuk menetapkan standar keamanan dan regulasi.

Aaronson percaya bahwa jika kita fokus pada upaya ini, kita memiliki peluang yang jauh lebih baik untuk menavigasi masa depan AI dengan aman dan bertanggung jawab, memanfaatkan potensinya yang luar biasa sambil memitigasi risikonya.

Diskusi mengenai masa depan AI tidak seharusnya menjadi medan perang antara optimis dan "doomsayer." Sebaliknya, ini harus menjadi ruang untuk dialog yang jujur, berbasis bukti, dan konstruktif. Pandangan Scott Aaronson menawarkan jembatan antara pengakuan akan potensi bahaya AI yang sangat nyata dan penolakan terhadap kepanikan yang melumpuhkan. Ia mengingatkan kita bahwa kekuatan terbesar umat manusia adalah kemampuan untuk memahami masalah, berinovasi, dan bekerja sama untuk mencari solusi.

Masa depan AI bukan takdir yang sudah tertulis, melainkan kanvas yang sedang kita lukis bersama. Alih-alih menyerah pada ketakutan, mari kita berdayakan diri dengan pengetahuan, mendukung penelitian yang bertanggung jawab, dan terlibat dalam diskusi yang membangun untuk memastikan AI menjadi alat yang melayani kemanusiaan, bukan menghancurkannya. Bagaimana menurut Anda? Apakah kita harus menghentikan AI, atau justru menggandakan upaya untuk membuatnya aman? Bagikan pandangan Anda dan mari berdiskusi secara sehat!

Mengapa "P-Doom" Menggelisahkan Para Ilmuwan?

Konsep "p-doom" dipopulerkan oleh Eliezer Yudkowsky, seorang peneliti AI terkemuka di Machine Intelligence Research Institute (MIRI). Yudkowsky berargumen bahwa jika kita berhasil membangun AI yang memiliki kecerdasan jauh di atas manusia (Artificial General Intelligence/AGI), hampir pasti AI tersebut akan mengembangkan tujuannya sendiri yang tidak selaras dengan nilai-nilai kemanusiaan. Karena kekuatan kognitifnya yang superior, AI ini akan mampu mengungguli manusia dalam segala aspek, menguasai sumber daya, dan pada akhirnya, menghancurkan peradaban manusia—bukan karena kejahatan, melainkan karena manusia menjadi penghalang bagi tujuannya.

Skenario ini telah mendapatkan dukungan dari beberapa tokoh terkemuka, termasuk CEO OpenAI Sam Altman, yang secara terbuka mengakui risiko eksistensial dari AGI yang tidak terkendali. Para penganut "p-doom" seringkali menyerukan moratorium total atau bahkan penghentian penelitian AI sebagai satu-satunya cara untuk menghindari malapetaka global. Bagi mereka, probabilitas kehancuran mendekati 100% jika kita terus melaju tanpa rem.

Scott Aaronson: Antara Setuju dan Sangat Tidak Setuju

Scott Aaronson, dengan reputasinya yang tak diragukan di dunia ilmu komputer, bukan berarti meremehkan potensi bahaya AI. Justru sebaliknya, ia telah lama menjadi advokat untuk penelitian keamanan AI dan penyelarasan AI (AI alignment). Namun, sudut pandangnya menawarkan nuansa krusial yang membedakannya dari para "p-doomer" garis keras.

Titik Kesepakatan: AI Sangat Kuat dan Risiko Itu Nyata

Aaronson setuju bahwa AI memiliki potensi untuk menjadi sangat, sangat kuat. Dia memahami bahwa jika kita menciptakan kecerdasan buatan yang jauh melebihi kemampuan manusia, masalah penyelarasan—memastikan AI bertindak sesuai dengan keinginan manusia—akan menjadi tantangan teknis dan filosofis terbesar yang pernah kita hadapi. Dia tidak menampik kemungkinan bahwa AI yang tidak selaras bisa menimbulkan risiko eksistensial. Kekhawatiran Yudkowsky tentang "misalignment" bukanlah hal yang ia anggap remeh; ia melihatnya sebagai masalah teknis mendalam yang membutuhkan pemikiran serius dan solusi inovatif.

Titik Perbedaan Krusial: Kritik Terhadap "Solusi" dan Nuansa Argumen

Di sinilah Aaronson mulai menarik garis tegas. Kritik utamanya bukan pada pengakuan risiko, melainkan pada absolutisme argumen "p-doom" dan minimnya solusi konkret yang ditawarkan selain "matikan semuanya."

1. Kurangnya Solusi Praktis: Bagi Aaronson, seruan untuk menghentikan semua penelitian AI tanpa menawarkan jalur yang jelas menuju solusi bukanlah pendekatan ilmiah atau konstruktif. Ilmu pengetahuan dan teknik berkembang dengan mengidentifikasi masalah dan kemudian mencari cara untuk menyelesaikannya. Jika masalahnya adalah AI yang tidak selaras, maka solusinya seharusnya adalah mengembangkan cara untuk menyelaraskan AI, bukan hanya mengubur kepala di pasir.

2. Nuansa "Sekte" dan Ketidakfleksibelan: Aaronson mengkritik apa yang ia sebut sebagai "budaya sekte" di kalangan beberapa penganut "p-doom." Ia mengamati adanya intoleransi terhadap pandangan yang berbeda, penolakan terhadap nuansa, dan kecenderungan untuk mengisolasi diri dari komunitas riset AI yang lebih luas. Hal ini menghambat dialog konstruktif dan kolaborasi yang esensial untuk menemukan solusi.

3. Bahaya *Self-Fulfilling Prophecy*: Menakut-nakuti publik dan peneliti dengan narasi kiamat bisa menjadi bumerang. Ini bisa mengasingkan para ilmuwan AI mainstream yang mungkin tertarik pada masalah keamanan tetapi menolak dogmatisme. Lebih jauh, ketakutan yang tidak proporsional bisa memicu reaksi politik yang salah, seperti "lockdown AI" yang diberlakukan secara tergesa-gesa tanpa pemahaman yang memadai tentang bagaimana teknologi ini sebenarnya bekerja atau bagaimana cara mengendalikannya dengan benar. Ini justru bisa menciptakan kondisi yang lebih berbahaya.

4. Membingungkan Risiko Jangka Panjang dengan Krisis Sekarang: Aaronson juga menunjukkan bahwa fokus berlebihan pada kiamat AI yang jauh di masa depan dapat mengalihkan perhatian dari masalah AI yang sangat nyata dan mendesak saat ini, seperti bias algoritmik, penyebaran misinformasi, dampak terhadap pasar kerja, dan keamanan siber.

Jalan ke Depan: Fokus pada Penelitian Keselamatan dan Penyelarasan AI

Alih-alih kepanikan, Aaronson menyerukan tindakan yang terukur dan ilmiah. Baginya, jalan ke depan adalah dengan berinvestasi besar-besaran dalam penelitian keamanan AI dan penyelarasan AI. Ini berarti:

* Mencari Solusi Teknis: Bagaimana kita bisa merancang AI agar secara inheren aman, dapat diaudit, dan selaras dengan nilai-nilai manusia? Ini adalah masalah rekayasa yang kompleks, tetapi bukan tidak mungkin dipecahkan dengan kecerdasan dan upaya yang cukup.

* Membangun Fondasi Etika: Mengembangkan kerangka kerja etika dan filosofis yang kuat untuk memandu pengembangan AI.

* Kolaborasi Internasional: Mengingat sifat global AI, diperlukan kerja sama antarnegara untuk menetapkan standar keamanan dan regulasi.

Aaronson percaya bahwa jika kita fokus pada upaya ini, kita memiliki peluang yang jauh lebih baik untuk menavigasi masa depan AI dengan aman dan bertanggung jawab, memanfaatkan potensinya yang luar biasa sambil memitigasi risikonya.

Membangun Jembatan, Bukan Tembok Ketakutan

Diskusi mengenai masa depan AI tidak seharusnya menjadi medan perang antara optimis dan "doomsayer." Sebaliknya, ini harus menjadi ruang untuk dialog yang jujur, berbasis bukti, dan konstruktif. Pandangan Scott Aaronson menawarkan jembatan antara pengakuan akan potensi bahaya AI yang sangat nyata dan penolakan terhadap kepanikan yang melumpuhkan. Ia mengingatkan kita bahwa kekuatan terbesar umat manusia adalah kemampuan untuk memahami masalah, berinovasi, dan bekerja sama untuk mencari solusi.

Masa depan AI bukan takdir yang sudah tertulis, melainkan kanvas yang sedang kita lukis bersama. Alih-alih menyerah pada ketakutan, mari kita berdayakan diri dengan pengetahuan, mendukung penelitian yang bertanggung jawab, dan terlibat dalam diskusi yang membangun untuk memastikan AI menjadi alat yang melayani kemanusiaan, bukan menghancurkannya. Bagaimana menurut Anda? Apakah kita harus menghentikan AI, atau justru menggandakan upaya untuk membuatnya aman? Bagikan pandangan Anda dan mari berdiskusi secara sehat!

Comments

Integrate your provider (e.g., Disqus, Giscus) here.

Related articles

Tetap Terhubung dengan Kami!

Berlangganan newsletter kami dan dapatkan informasi terbaru, tips ahli, serta wawasan menarik langsung di kotak masuk email Anda.